Стадия жизненного цикла модуля: General Availability

Введение

Данное руководство предназначено для пользователей модуля virtualization в экосистеме Deckhouse и описывает порядок создания и изменения ресурсов, которые доступны для создания в проектах и пространствах имён кластера.

Быстрый старт по созданию ВМ

Пример создания виртуальной машины с Ubuntu 22.04.

-

Создайте образ виртуальной машины из внешнего источника:

d8 k apply -f - <<EOF apiVersion: virtualization.deckhouse.io/v1alpha2 kind: VirtualImage metadata: name: ubuntu spec: storage: ContainerRegistry dataSource: type: HTTP http: url: https://cloud-images.ubuntu.com/noble/current/noble-server-cloudimg-amd64.img EOFКак создать образ виртуальной машины из внешнего источника в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Образы дисков».

- Нажмите «Создать образ».

- Из списка выберите «Загрузить данные по ссылке (HTTP)».

- В открывшейся форме в поле «Имя образа» введите

ubuntu. - В поле «Хранилище» выберите

ContainerRegistry. - В поле «URL» вставьте

https://cloud-images.ubuntu.com/noble/current/noble-server-cloudimg-amd64.img. - Нажмите кнопку «Создать».

- Статус образа отображается слева вверху, под именем образа.

-

Создайте диск виртуальной машины из образа, созданного на предыдущем шаге (Внимание: перед созданием убедитесь, что в системе присутствует StorageClass по умолчанию):

d8 k apply -f - <<EOF apiVersion: virtualization.deckhouse.io/v1alpha2 kind: VirtualDisk metadata: name: linux-disk spec: dataSource: type: ObjectRef objectRef: kind: VirtualImage name: ubuntu EOFКак создать диск виртуальной машины из образа, созданного на предыдущем шаге, в веб-интерфейсе (данный шаг можно пропустить и выполнить при создании ВМ):

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Диски ВМ».

- Нажмите «Создать диск».

- В открывшейся форме в поле «Имя диска» введите

linux-disk. - В поле «Источник» убедитесь, что установлен чек-бокс «Проектные».

- Из выпадающего списка выберите

ubuntu. - В поле «Размер» можете изменить размер на больший, например на

5Gi. - В поле «Имя StorageClass» можно выбрать StorageClass или оставить выбранный по умолчанию.

- Нажмите кнопку «Создать».

- Статус диска отображается слева вверху, под именем диска.

Помните, если Ваш StorageClass имеет настройку WaitForFirstConsumer, диск будет ожидать создания ВМ с этим диском. Статус диска в этом случае

СОЗДАНИЕ 0%, но диск уже можно будет выбирать при создании ВМ, см. раздел диски -

Создайте виртуальную машину:

В примере используется cloud-init-сценарий для создания пользователя cloud с паролем cloud, сгенерированный следующим образом:

mkpasswd --method=SHA-512 --rounds=4096Изменить имя пользователя и пароль можно в этой секции:

users: - name: cloud passwd: $6$rounds=4096$G5VKZ1CVH5Ltj4wo$g.O5RgxYz64ScD5Ach5jeHS.Nm/SRys1JayngA269wjs/LrEJJAZXCIkc1010PZqhuOaQlANDVpIoeabvKK4j1Создайте виртуальную машину из следующей спецификации:

d8 k apply -f - <<EOF apiVersion: virtualization.deckhouse.io/v1alpha2 kind: VirtualMachine metadata: name: linux-vm spec: virtualMachineClassName: generic cpu: cores: 1 memory: size: 1Gi provisioning: type: UserData userData: | #cloud-config ssh_pwauth: True users: - name: cloud passwd: "$6$rounds=4096$saltsalt$fPmUsbjAuA7mnQNTajQM6ClhesyG0.yyQhvahas02ejfMAq1ykBo1RquzS0R6GgdIDlvS.kbUwDablGZKZcTP/" shell: /bin/bash sudo: ALL=(ALL) NOPASSWD:ALL lock_passwd: False blockDeviceRefs: - kind: VirtualDisk name: linux-disk EOFКак создать виртуальную машину в веб-интерфейсе:

-

Перейдите на вкладку «Проекты» и выберите нужный проект.

-

Перейдите в раздел «Виртуализация» → «Виртуальные машины»

-

Нажмите «Создать».

-

В открывшейся форме в поле «Имя» введите

linux-vm. -

В разделе «Параметры машины» настройки можно оставить по умолчанию.

-

В разделе «Диски и образы» в подразделе «Загрузочные диски» нажмите «Добавить».

Если вы уже создали диск:

- В открывшейся форме нажмите «Выбрать из существующих».

- В списке выберите диск

linux-disk.

Если вы не создавали диск:

- В открывшейся форме нажмите «Создать новый диск».

- В поле «Имя» введите

linux-disk. - В поле «Источник» нажмите на стрелку, чтобы развернуть список и убедитесь, что установлен чек-бокс «Проектные».

- Из выпадающего списка выберите

ubuntu. - В поле «Размер» можете изменить размер на больший, например на

5Gi. - В поле «Класс хранилища» можно выбрать StorageClass или оставить выбранный по умолчанию.

- Нажмите кнопку «Создать и добавить».

-

Прокрутите страницу вниз до раздела «Дополнительные параметры».

-

Включите переключатель «Cloud-init».

-

В появившееся поле вставьте ваши данные:

#cloud-config ssh_pwauth: True users: - name: cloud passwd: "$6$rounds=4096$saltsalt$fPmUsbjAuA7mnQNTajQM6ClhesyG0.yyQhvahas02ejfMAq1ykBo1RquzS0R6GgdIDlvS.kbUwDablGZKZcTP/" shell: /bin/bash sudo: ALL=(ALL) NOPASSWD:ALL lock_passwd: False -

Нажмите кнопку «Создать».

-

Статус ВМ отображается слева вверху, под ее именем.

Полезные ссылки:

-

-

Проверьте с помощью команды, что образ и диск созданы, а виртуальная машина запущена. Ресурсы создаются не мгновенно, поэтому прежде чем они перейдут в готовое состояние потребуется подождать какое-то время.

d8 k get vi,vd,vmПример вывода:

NAME PHASE CDROM PROGRESS AGE virtualimage.virtualization.deckhouse.io/ubuntu Ready false 100% # NAME PHASE CAPACITY AGE virtualdisk.virtualization.deckhouse.io/linux-disk Ready 300Mi 7h40m # NAME PHASE NODE IPADDRESS AGE virtualmachine.virtualization.deckhouse.io/linux-vm Running virtlab-pt-2 10.66.10.2 7h46m -

Подключитесь с помощью консоли к виртуальной машине (для выхода из консоли необходимо нажать

Ctrl+]):d8 v console linux-vmПример вывода:

Successfully connected to linux-vm console. The escape sequence is ^] # linux-vm login: cloud Password: cloud ... cloud@linux-vm:~$Как подключиться к виртуальной машине с помощью консоли в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация" -> «Виртуальные машины»

- Из списка выберите необходимую ВМ и нажмите на её имя.

- В открывшейся форме перейдите на вкладку «TTY»

- Перейдите в открывшееся окно консоли. Здесь можно подключиться к ВМ.

-

Для удаления созданных ранее ресурсов используйте следующие команды:

d8 k delete vm linux-vm d8 k delete vd linux-disk d8 k delete vi ubuntu

Образы

Ресурс VirtualImage предназначен для загрузки образов виртуальных машин и их последующего использования для создания дисков виртуальных машин.

Обратите внимание, что VirtualImage — это проектный ресурс, то есть он доступен только в том проекте или пространстве имен, в котором был создан. Для использования образов на уровне всего кластера предназначен отдельный ресурс — ClusterVirtualImage.

При подключении к виртуальной машине доступ к образу предоставляется в режиме «только чтение».

Процесс создания образа включает следующие шаги:

- Пользователь создаёт ресурс

VirtualImage. - После создания образ автоматически загружается из указанного в спецификации источника в хранилище DVCR или PVC в зависимости от типа.

- После завершения загрузки, ресурс становится доступным для создания дисков.

Существуют различные типы образов:

- ISO-образ — установочный образ, используемый для начальной установки операционной системы. Такие образы выпускаются производителями ОС и используются для установки на физические и виртуальные серверы.

- Образ диска с предустановленной системой — содержит уже установленную и настроенную операционную систему, готовую к использованию после создания виртуальной машины. Готовые образы можно получить на ресурсах разработчиков дистрибутива, либо создать самостоятельно.

Примеры ресурсов для получения образов виртуальной машины:

| Дистрибутив | Пользователь по умолчанию |

|---|---|

| AlmaLinux | almalinux |

| AlpineLinux | alpine |

| AltLinux | altlinux |

| AstraLinux | astra |

| CentOS | cloud-user |

| Debian | debian |

| Rocky | rocky |

| Ubuntu | ubuntu |

Поддерживаются следующие форматы образов с предустановленной системой:

- qcow2

- raw

- vmdk

- vdi

Также файлы образов могут быть сжаты одним из следующих алгоритмов сжатия: gz, xz.

После создания ресурса, тип и размер образа определяются автоматически и эта информация отражается в статусе ресурса.

Образы могут быть загружены из различных источников, таких как HTTP-серверы, где расположены файлы образов, или контейнерные реестры. Также доступна возможность загрузки образов напрямую из командной строки с использованием утилиты curl.

Образы могут быть созданы из других образов и дисков виртуальных машин.

Проектный образ поддерживает два варианта хранения:

ContainerRegistry- тип по умолчанию, при котором образ хранится вDVCR.PersistentVolumeClaim- тип, при котором в качестве хранилища для образа используетсяPVC. Этот вариант предпочтителен, если используется хранилище с поддержкой быстрого клонированияPVC, что позволяет быстрее создавать диски из образов.

Использование образа с параметром storage: PersistentVolumeClaim поддерживается только для создания дисков в том же классе хранения (StorageClass).

С полным описанием параметров конфигурации ресурса VirtualImage можно ознакомиться в документации к ресурсу.

Создание образа с HTTP-сервера

Рассмотрим вариант создания образа с вариантом хранения в DVCR.

-

Выполните следующую команду для создания

VirtualImage:d8 k apply -f - <<EOF apiVersion: virtualization.deckhouse.io/v1alpha2 kind: VirtualImage metadata: name: ubuntu-22-04 spec: # Сохраним образ в DVCR. storage: ContainerRegistry # Источник для создания образа. dataSource: type: HTTP http: url: https://cloud-images.ubuntu.com/noble/current/noble-server-cloudimg-amd64.img EOF -

Проверьте результат создания

VirtualImage:d8 k get virtualimage ubuntu-22-04 # или более короткий вариант d8 k get vi ubuntu-22-04Пример вывода:

NAME PHASE CDROM PROGRESS AGE ubuntu-22-04 Ready false 100% 23h

После создания ресурс VirtualImage может находиться в следующих состояниях (фазах):

Pending- ожидание готовности всех зависимых ресурсов, требующихся для создания образа.WaitForUserUpload- ожидание загрузки образа пользователем (фаза присутствует только дляtype=Upload).Provisioning- идет процесс создания образа.Ready- образ создан и готов для использования.Failed- произошла ошибка в процессе создания образа.Terminating- идет процесс удаления Образа. Образ может «зависнуть» в данном состоянии, если он еще подключен к виртуальной машине.

До тех пор пока образ не перешёл в фазу Ready, содержимое всего блока .spec допускается изменять. При изменении процесс создании диска запустится заново. После перехода в фазу Ready содержимое блока .spec менять нельзя!

Диагностика проблем с ресурсом осуществляется путем анализа информации в блоке .status.conditions.

Отследить процесс создания образа можно путем добавления ключа -w к предыдущей команде:

d8 k get vi ubuntu-22-04 -w

Пример вывода:

NAME PHASE CDROM PROGRESS AGE

ubuntu-22-04 Provisioning false 4s

ubuntu-22-04 Provisioning false 0.0% 4s

ubuntu-22-04 Provisioning false 28.2% 6s

ubuntu-22-04 Provisioning false 66.5% 8s

ubuntu-22-04 Provisioning false 100.0% 10s

ubuntu-22-04 Provisioning false 100.0% 16s

ubuntu-22-04 Ready false 100% 18s

В описание ресурса VirtualImage можно получить дополнительную информацию о скачанном образе:

d8 k describe vi ubuntu-22-04

Как создать образ с HTTP-сервера в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Образы дисков».

- Нажмите «Создать образ».

- Из списка выберите «Загрузить данные по ссылке (HTTP)».

- В открывшейся форме в поле «Имя образа» введите имя образа.

- В поле «Хранилище» выберите

ContainerRegistry. - В поле «URL» укажите ссылку на образ.

- Нажмите кнопку «Создать».

- Статус образа отображается слева вверху, под именем образа.

Теперь рассмотрим пример создания образа с хранением его в PVC:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualImage

metadata:

name: ubuntu-22-04-pvc

spec:

# Настройки хранения проектного образа.

storage: PersistentVolumeClaim

persistentVolumeClaim:

# Подставьте ваше название StorageClass.

storageClassName: i-sds-replicated-thin-r2

# Источник для создания образа.

dataSource:

type: HTTP

http:

url: https://cloud-images.ubuntu.com/noble/current/noble-server-cloudimg-amd64.img

EOF

Проверьте результат создания VirtualImage:

d8 k get vi ubuntu-22-04-pvc

Пример вывода:

NAME PHASE CDROM PROGRESS AGE

ubuntu-22-04-pvc Ready false 100% 23h

Если параметр .spec.persistentVolumeClaim.storageClassName не указан, то будет использован StorageClass по умолчанию на уровне кластера, либо для образов, если он указан в настройках модуля.

Как в веб-интерфейсе создать образ с его хранением в PVC:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Образы дисков».

- Нажмите «Создать образ».

- Из списка выберите «Загрузить данные по ссылке (HTTP)».

- В открывшейся форме в поле «Имя образа» введите имя образа.

- В поле «Хранилище» выберите

PersistentVolumeClaim. - В поле «Класс хранилища» можно выбрать StorageClass или оставить выбранный по умолчанию.

- В поле «URL» укажите ссылку на образ.

- Нажмите кнопку «Создать».

- Статус образа отображается слева вверху, под именем образа.

Создание образа из Container Registry

Образ, хранящийся в Container Registry, имеет определенный формат. Рассмотрим на примере:

-

Загрузите образ локально:

curl -L https://cloud-images.ubuntu.com/minimal/releases/jammy/release/ubuntu-22.04-minimal-cloudimg-amd64.img -o ubuntu2204.img -

Создайте

Dockerfileсо следующим содержимым:FROM scratch COPY ubuntu2204.img /disk/ubuntu2204.img -

Соберите образ и загрузите его в container registry. В качестве container registry в примере ниже использован docker.io. Для выполнения необходимо иметь учетную запись сервиса и настроенное окружение.

docker build -t docker.io/<username>/ubuntu2204:latestгде

username— имя пользователя, указанное при регистрации в docker.io. -

Загрузите созданный образ в container registry:

docker push docker.io/<username>/ubuntu2204:latest -

Чтобы использовать этот образ, создайте в качестве примера ресурс:

d8 k apply -f - <<EOF apiVersion: virtualization.deckhouse.io/v1alpha2 kind: VirtualImage metadata: name: ubuntu-2204 spec: storage: ContainerRegistry dataSource: type: ContainerImage containerImage: image: docker.io/<username>/ubuntu2204:latest EOF

Как создать образ из Container Registry в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Образы дисков».

- Нажмите «Создать образ».

- Из списка выберите «Загрузить данные из образа контейнера».

- В открывшейся форме в поле «Имя образа» введите имя образа.

- В поле «Хранилище» выберите

ContainerRegistry. - В поле «Образ в реестре контейнеров» укажите

docker.io/<username>/ubuntu2204:latest. - Нажмите кнопку «Создать».

- Статус образа отображается слева вверху, под именем образа.

Загрузка образа из командной строки

Чтобы загрузить образ из командной строки, предварительно создайте ресурс, как представлено ниже на примере VirtualImage:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualImage

metadata:

name: some-image

spec:

# Настройки хранения проектного образа.

storage: ContainerRegistry

# Настройки источника образа.

dataSource:

type: Upload

EOF

После создания, ресурс перейдет в фазу WaitForUserUpload, а это значит, что он готов для загрузки образа.

Доступно два варианта загрузки с узла кластера и с произвольного узла за пределами кластера:

d8 k get vi some-image -o jsonpath="{.status.imageUploadURLs}" | jq

Пример вывода:

{

"external": "https://virtualization.example.com/upload/g2OuLgRhdAWqlJsCMyNvcdt4o5ERIwmm",

"inCluster": "http://10.222.165.239/upload"

}

В качестве примера загрузите образ Cirros:

curl -L http://download.cirros-cloud.net/0.5.1/cirros-0.5.1-x86_64-disk.img -o cirros.img

Выполните загрузку образа с использование следующей команды

curl https://virtualization.example.com/upload/g2OuLgRhdAWqlJsCMyNvcdt4o5ERIwmm --progress-bar -T cirros.img | cat

После завершения загрузки образ должен быть создан и перейти в фазу Ready

d8 k get vi some-image

Пример вывода:

NAME PHASE CDROM PROGRESS AGE

some-image Ready false 100% 1m

Как загрузить образ из командной строки в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Образы дисков».

- Нажмите «Создать образ», далее в выпадающем меню выберите «Загрузить с компьютера».

- В поле «Имя образа» введите имя образа.

- В поле «Загрузить файл» нажмите ссылку «Выберите файл на вашем компьютере».

- Выберите файл в открывшемся файловом менеджере.

- Нажмите кнопку «Создать».

- Дождитесь пока образ перейдет в состояние

Готов.

Создание образа из диска

Существует возможность создать образ из диска. Для этого необходимо выполнить одно из следующих условий:

- Диск не подключен ни к одной из виртуальных машин.

- Виртуальная машина, к которой подключен диск, находится в выключенном состоянии.

Пример создания образа из диска:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualImage

metadata:

name: linux-vm-root

spec:

storage: ContainerRegistry

dataSource:

type: ObjectRef

objectRef:

kind: VirtualDisk

name: linux-vm-root

EOF

Как в веб-интерфейсе создать образ из диска:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Образы дисков».

- Нажмите «Создать образ».

- Из списка выберите «Записать данные из диска».

- В открывшейся форме в поле «Имя образа» введите

linux-vm-root. - В поле «Хранилище» выберите

ContainerRegistry. - В поле «Диск» выберите из выпадающего списка необходимый диск.

- Нажмите кнопку «Создать».

- Статус образа отображается слева вверху, под его именем.

Создание образа из снимка диска

Можно создать образ из снимка. Для этого необходимо чтобы снимок диска находился в фазе готовности.

Пример создания образа из моментального снимка диска:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualImage

metadata:

name: linux-vm-root

spec:

storage: ContainerRegistry

dataSource:

type: ObjectRef

objectRef:

kind: VirtualDiskSnapshot

name: linux-vm-root-snapshot

EOF

Диски

Диски в виртуальных машинах используются для записи и хранения данных, что необходимо для работы операционных систем и приложений. Для этих целей можно использовать различные типы хранилищ.

В зависимости от выбранного типа хранилища, поведение дисков при создании виртуальных машин и в процессе эксплуатации может отличаться.

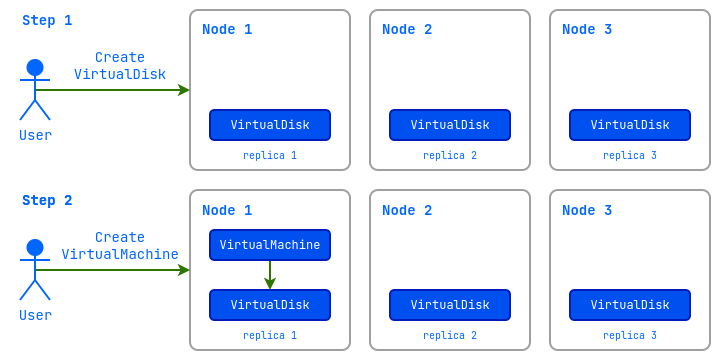

Параметр VolumeBindingMode:

Immediate - Диск создается сразу после создания ресурса (предполагается, что диск будет доступен для подключения к виртуальной машине на любом узле кластера).

WaitForFirstConsumer - Диск создается только после того, как будет подключен к виртуальной машине и будет создан на том узле, на котором будет запущена виртуальная машина.

Режим доступа AccessMode:

ReadWriteMany (RWX)- множественный доступ к диску. Живая миграция виртуальных машин с такими дисками возможна.ReadWriteOnce (RWO)- доступ к диску предоставляется только одному экземпляру виртуальной машины. Живая миграция виртуальных машин с такими дисками поддерживается только для платных редакций. Живая миграция доступна только если все диски подключены статически через.spec.blockDeviceRefs. Диски, подключенные динамически через VirtualMachineBlockDeviceAttachments, необходимо статически переподключить, указав их в.spec.blockDeviceRefs.

При создании диска контроллер самостоятельно определит наиболее оптимальные параметры поддерживаемые хранилищем.

Внимание: Создать диски из iso-образов - нельзя!

Чтобы узнать доступные варианты хранилищ, выполните следующую команду:

d8 k get storageclass

Пример вывода:

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE

i-sds-replicated-thin-r1 (default) replicated.csi.storage.deckhouse.io Delete Immediate true 48d

i-sds-replicated-thin-r2 replicated.csi.storage.deckhouse.io Delete Immediate true 48d

i-sds-replicated-thin-r3 replicated.csi.storage.deckhouse.io Delete Immediate true 48d

sds-replicated-thin-r1 replicated.csi.storage.deckhouse.io Delete WaitForFirstConsumer true 48d

sds-replicated-thin-r2 replicated.csi.storage.deckhouse.io Delete WaitForFirstConsumer true 48d

sds-replicated-thin-r3 replicated.csi.storage.deckhouse.io Delete WaitForFirstConsumer true 48d

nfs-4-1-wffc nfs.csi.k8s.io Delete WaitForFirstConsumer true 30d

С полным описанием параметров конфигурации дисков можно ознакомиться в документации ресурса.

Как узнать доступные варианты хранилищ в веб-интерфейсе:

- Перейдите на вкладку «Система», далее в раздел «Хранилище» → «Классы хранилищ».

Создание пустого диска

Пустые диски обычно используются для установки на них ОС, либо для хранения каких-либо данных.

Создайте диск:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualDisk

metadata:

name: blank-disk

spec:

# Настройки параметров хранения диска.

persistentVolumeClaim:

# Подставьте ваше название StorageClass.

storageClassName: i-sds-replicated-thin-r2

size: 100Mi

EOF

После создания ресурс VirtualDisk может находиться в следующих состояниях (фазах):

Pending- ожидание готовности всех зависимых ресурсов, требующихся для создания диска.Provisioning- идет процесс создания диска.Resizing- идет процесс изменения размера диска.WaitForFirstConsumer- диск ожидает создания виртуальной машины, которая будет его использовать.WaitForUserUpload- диск ожидает от пользователя загрузки образа (type: Upload).Ready- диск создан и готов для использования.Migrating- живая миграция диска.Failed- произошла ошибка в процессе создания.PVCLost- системная ошибка, PVC с данными утерян.Terminating- идет процесс удаления диска. Диск может «зависнуть» в данном состоянии, если он еще подключен к виртуальной машине.

До тех пор, пока диск не перешёл в фазу Ready, можно изменять любые поля блока .spec. При изменении процесс создания диска будет запущен заново.

Диагностика проблем с ресурсом осуществляется путем анализа информации в блоке .status.conditions.

Если параметр .spec.persistentVolumeClaim.storageClassName не указан, то будет использован StorageClass по умолчанию на уровне кластера, либо для образов, если он указан в настройках модуля.

Проверьте состояние диска после создания командой:

d8 k get vd blank-disk

Пример вывода:

NAME PHASE CAPACITY AGE

blank-disk Ready 100Mi 1m2s

Как создать пустой диск в веб-интерфейсе (данный шаг можно пропустить и выполнить при создании ВМ):

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Диски ВМ».

- Нажмите «Создать диск».

- В открывшейся форме в поле «Имя диска» введите

blank-disk. - В поле «Размер» задайте размер с единицами измерений

100Mi. - В поле «Имя StorageClass» можно выбрать StorageClass или оставить выбранный по умолчанию.

- Нажмите кнопку «Создать».

- Статус диска отображается слева вверху, под именем диска.

Создание диска из образа

Диск также можно создавать и заполнять данными из ранее созданных образов ClusterVirtualImage и VirtualImage.

При создании диска можно указать его желаемый размер, который должен быть равен или больше размера распакованного образа. Если размер не указан, то будет создан диск с размером, соответствующим исходному образу диска.

На примере ранее созданного проектного образа VirtualImage, рассмотрим команду позволяющую определить размер распакованного образа:

d8 k get vi ubuntu-22-04 -o wide

Пример вывода:

NAME PHASE CDROM PROGRESS STOREDSIZE UNPACKEDSIZE REGISTRY URL AGE

ubuntu-22-04 Ready false 100% 285.9Mi 2.5Gi dvcr.d8-virtualization.svc/cvi/ubuntu-22-04:eac95605-7e0b-4a32-bb50-cc7284fd89d0 122m

Искомый размер указан в колонке UNPACKEDSIZE и равен 2.5Gi.

Создадим диск из этого образа:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualDisk

metadata:

name: linux-vm-root

spec:

# Настройки параметров хранения диска.

persistentVolumeClaim:

# Укажем размер больше чем значение распакованного образа.

size: 10Gi

# Подставьте ваше название StorageClass.

storageClassName: i-sds-replicated-thin-r2

# Источник из которого создается диск.

dataSource:

type: ObjectRef

objectRef:

kind: VirtualImage

name: ubuntu-22-04

EOF

А теперь создайте диск, без явного указания размера:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualDisk

metadata:

name: linux-vm-root-2

spec:

# Настройки параметров хранения диска.

persistentVolumeClaim:

# Подставьте ваше название StorageClass.

storageClassName: i-sds-replicated-thin-r2

# Источник из которого создается диск.

dataSource:

type: ObjectRef

objectRef:

kind: VirtualImage

name: ubuntu-22-04

EOF

Проверьте состояние дисков после создания:

d8 k get vd

Пример вывода:

NAME PHASE CAPACITY AGE

linux-vm-root Ready 10Gi 7m52s

linux-vm-root-2 Ready 2590Mi 7m15s

Как создать диск из образа в веб-интерфейсе (данный шаг можно пропустить и выполнить при создании ВМ):

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Диски ВМ».

- Нажмите «Создать диск».

- В открывшейся форме в поле «Имя диска» введите

linux-vm-root. - В поле «Источник» убедитесь, что установлен чек-бокс «Проектные».

- Из выпадающего списка выберите интересующий Вас образ.

- В поле «Размер» можете изменить размер на больший или оставить выбранный по умолчанию.

- В поле «Имя StorageClass» можно выбрать StorageClass или оставить выбранный по умолчанию.

- Нажмите кнопку «Создать».

- Статус диска отображается слева вверху, под именем диска.

Загрузка диска из командной строки

Чтобы загрузить диск из командной строки, предварительно создайте ресурс, как представлено ниже на примере VirtualDisk:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualDisk

metadata:

name: uploaded-disk

spec:

dataSource:

type: Upload

EOF

После создания ресурс перейдет в фазу WaitForUserUpload, что означает, что он готов для загрузки диска.

Доступно два варианта загрузки: с узла кластера и с произвольного узла за пределами кластера:

d8 k get vd uploaded-disk -o jsonpath="{.status.imageUploadURLs}" | jq

Пример вывода:

{

"external": "https://virtualization.example.com/upload/<secret-url>",

"inCluster": "http://10.222.165.239/upload"

}

Выполните загрузку диска с использованием следующей команды:

curl https://virtualization.example.com/upload/<secret-url> --progress-bar -T <image.name> | cat

После завершения загрузки диск должен быть создан и перейти в фазу Ready:

d8 k get vd uploaded-disk

Пример вывода:

NAMESPACE NAME PHASE CAPACITY AGE

default uploaded-disk Ready 3Gi 7d23h

Изменение размера диска

Размер дисков можно увеличивать, даже если они уже подключены к работающей виртуальной машине. Для этого отредактируйте поле spec.persistentVolumeClaim.size:

Проверьте размер до изменения:

d8 k get vd linux-vm-root

Пример вывода:

NAME PHASE CAPACITY AGE

linux-vm-root Ready 10Gi 10m

Примените изменения:

d8 k patch vd linux-vm-root --type merge -p '{"spec":{"persistentVolumeClaim":{"size":"11Gi"}}}'

# Или внесите аналогичные изменения, отредактировав ресурс.

d8 k edit vd linux-vm-root

Проверьте размер после изменения:

d8 k get vd linux-vm-root

Пример вывода:

NAME PHASE CAPACITY AGE

linux-vm-root Ready 11Gi 12m

Как изменить размер диска в веб-интерфейсе:

Способ №1:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Диски ВМ».

- Выберите нужный диск и нажмите на символ карандаша в колонке «Размер».

- Во всплывающем окне можете изменить размер на больший.

- Нажмите на кнопку «Применить».

- Статус диска отображается в колонке «Статус».

Способ №2:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Диски ВМ».

- Выберите нужный диск и нажмите на его имя.

- В открывшейся форме на вкладке «Конфигурация» в поле «Размер» можете изменить размер на больший.

- Нажмите на появившуюся кнопку «Сохранить».

- Статус диска отображается слева вверху, под его именем.

Миграция дисков на другие хранилища

В платных редакциях вы можете мигрировать (перенести) диск виртуальной машины на другое хранилище, изменив для него класс хранилища (StorageClass).

Ограничения миграции дисков между хранилищами:

- Миграция доступна только для виртуальных машин в состоянии

Running. - Миграция поддерживается только между дисками одного типа:

Block↔Block,FileSystem↔FileSystem; перевод между разными типами невозможен. - Миграция поддерживается только для дисков, подключённых статически через параметр

.spec.blockDeviceRefsв спецификации виртуальной машины. - Если диск был подключён посредством ресурса VirtualMachineBlockDeviceAttachments, для выполнения миграции его необходимо временно переподключить напрямую, указав имя диска в

.spec.blockDeviceRefs.

Пример миграции диска на класс хранения new-storage-class-name:

d8 k patch vd disk --type=merge --patch '{"spec":{"persistentVolumeClaim":{"storageClassName":"new-storage-class-name"}}}'

# Или внесите аналогичные изменения, отредактировав ресурс.

d8 k edit vd disk

После изменения конфигурации диска запустится живая миграция ВМ, в процессе которой диск ВМ будет перемещен в новое хранилище.

Если к виртуальной машине подключены несколько дисков и требуется изменить класс хранения для нескольких дисков, эту операцию необходимо выполнить последовательно:

d8 k patch vd disk1 --type=merge --patch '{"spec":{"persistentVolumeClaim":{"storageClassName":"new-storage-class-name"}}}'

d8 k patch vd disk2 --type=merge --patch '{"spec":{"persistentVolumeClaim":{"storageClassName":"new-storage-class-name"}}}'

При неуспешной миграции повторные попытки выполняются с увеличивающимися задержками (алгоритм экспоненциального backoff). Максимальная задержка — 300 секунд (5 минут). Задержки: 5 секунд (1-я попытка), 10 секунд (2-я), далее каждая задержка удваивается, достигая 300 секунд (7-я и последующие попытки). Первая попытка выполняется без задержки.

Для отмены миграции пользователь должен вернуть класс хранения в спецификации на исходный.

Виртуальные машины

Для создания виртуальной машины используется ресурс VirtualMachine. Его параметры позволяют сконфигурировать:

- класс виртуальной машины;

- ресурсы, требуемые для работы виртуальной машины (процессор, память, диски и образы);

- правила размещения виртуальной машины на узлах кластера;

- настройки загрузчика и оптимальные параметры для гостевой ОС;

- политику запуска виртуальной машины и политику применения изменений;

- сценарии начальной конфигурации (cloud-init);

- перечень блочных устройств.

С полным описанием параметров конфигурации виртуальных машин можно ознакомиться по в документации конфигурации.

Создание виртуальной машины

Ниже представлен пример конфигурации виртуальной машины, запускающей ОС Ubuntu 22.04. В примере используется сценарий первичной инициализации виртуальной машины (cloud-init), который устанавливает гостевого агента qemu-guest-agent и сервис nginx, а также создает пользователя cloud с паролем cloud:

Пароль в примере был сгенерирован с использованием команды mkpasswd --method=SHA-512 --rounds=4096 -S saltsalt и при необходимости вы можете его поменять на свой:

Создайте виртуальную машину с диском созданным ранее:

d8 k apply -f - <<"EOF"

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualMachine

metadata:

name: linux-vm

spec:

# Название класса ВМ.

virtualMachineClassName: generic

# Блок скриптов первичной инициализации ВМ.

provisioning:

type: UserData

# Пример cloud-init-сценария для создания пользователя cloud с паролем cloud и установки сервиса агента qemu-guest-agent и сервиса nginx.

userData: |

#cloud-config

package_update: true

packages:

- nginx

- qemu-guest-agent

runcmd:

- systemctl daemon-reload

- systemctl enable --now nginx.service

- systemctl enable --now qemu-guest-agent.service

ssh_pwauth: True

users:

- name: cloud

passwd: "$6$rounds=4096$saltsalt$fPmUsbjAuA7mnQNTajQM6ClhesyG0.yyQhvahas02ejfMAq1ykBo1RquzS0R6GgdIDlvS.kbUwDablGZKZcTP/"

shell: /bin/bash

sudo: ALL=(ALL) NOPASSWD:ALL

lock_passwd: False

final_message: "The system is finally up, after $UPTIME seconds"

# Настройки ресурсов ВМ.

cpu:

# Количество ядер ЦП.

cores: 1

# Запросить 10% процессорного времени одного физического ядра.

coreFraction: 10%

memory:

# Объем оперативной памяти.

size: 1Gi

# Список дисков и образов, используемых в ВМ.

blockDeviceRefs:

# Порядок дисков и образов в данном блоке определяет приоритет загрузки.

- kind: VirtualDisk

name: linux-vm-root

EOF

Проверьте состояние виртуальной машины после создания:

d8 k get vm linux-vm

Пример вывода:

NAME PHASE NODE IPADDRESS AGE

linux-vm Running virtlab-pt-2 10.66.10.12 11m

После создания виртуальная машина автоматически получит IP-адрес из диапазона, указанного в настройках модуля (блок virtualMachineCIDRs).

Как создать виртуальную машину в веб-интерфейсе:

-

Перейдите на вкладку «Проекты» и выберите нужный проект.

-

Перейдите в раздел «Виртуализация» → «Виртуальные машины».

-

Нажмите «Создать».

-

В открывшейся форме в поле «Имя» введите

linux-vm. -

В разделе «Параметры машины» в поле «Ядер» задайте

1. -

В разделе «Параметры машины» в поле «Доля ЦП» задайте

10%. -

В разделе «Параметры машины» в поле «Размер» задайте

1Gi. -

В разделе «Диски и образы» в подразделе «Загрузочные диски» нажмите «Добавить».

-

В открывшейся форме нажмите «Выбрать из существующих».

-

В списке выберите диск

linux-vm-root. -

Прокрутите страницу вниз до раздела «Дополнительные параметры».

-

Включите переключатель «Cloud-init».

-

В появившееся поле вставьте ваши данные:

#cloud-config package_update: true packages: - nginx - qemu-guest-agent runcmd: - systemctl daemon-reload - systemctl enable --now nginx.service - systemctl enable --now qemu-guest-agent.service ssh_pwauth: True users: - name: cloud passwd: "$6$rounds=4096$saltsalt$fPmUsbjAuA7mnQNTajQM6ClhesyG0.yyQhvahas02ejfMAq1ykBo1RquzS0R6GgdIDlvS.kbUwDablGZKZcTP/" shell: /bin/bash sudo: ALL=(ALL) NOPASSWD:ALL lock_passwd: False final_message: "The system is finally up, after $UPTIME seconds" -

Нажмите кнопку «Создать».

-

Статус ВМ отображается слева вверху, под ее именем.

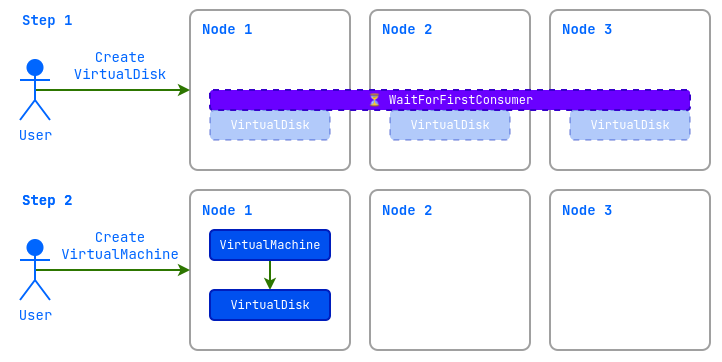

Жизненный цикл ВМ

Виртуальная машина проходит через несколько этапов своего существования — от создания до удаления. Эти этапы называются фазами и отражают текущее состояние ВМ. Чтобы понять, что происходит с ВМ, нужно проверить её статус (поле .status.phase), а для более детальной информации — блок .status.conditions. Ниже описаны все основные фазы жизненного цикла ВМ, их значение и особенности.

-

Pending- ожидание готовности ресурсовВМ только что создана, перезапущена или запущена после остановки и ожидает готовности необходимых ресурсов (дисков, образов, ip-адресов и т.д.).

-

Возможные проблемы:

- не готовы зависимые ресурсы: диски, образы, классы ВМ, секрет со сценарием начальной конфигурации и пр.

-

Диагностика: В

.status.conditionsстоит обратить внимание на условия*Ready. По ним можно определить, что блокирует переход к следующей фазе, например, ожидание готовности дисков (BlockDevicesReady) или класса ВМ (VirtualMachineClassReady).d8 k get vm <vm-name> -o json | jq '.status.conditions[] | select(.type | test(".*Ready"))'

-

-

Starting- запуск виртуальной машиныВсе зависимые ресурсы ВМ - готовы, и система пытается запустить ВМ на одном из узлов кластера.

-

Возможные проблемы:

- Нет подходящего узла для запуска.

- На подходящих узлах недостаточно CPU или памяти.

- Превышены квоты неймспейса или проекта.

-

Диагностика:

- Если запуск затягивается, проверьте

.status.conditions, условиеtype: Running

d8 k get vm <vm-name> -o json | jq '.status.conditions[] | select(.type=="Running")' - Если запуск затягивается, проверьте

-

-

Running- виртуальная машина запущенаВМ успешно запущена и работает.

-

Особенности:

- При установленном в гостевой системе qemu-guest-agent, условие

AgentReadyбудет истинно,а в.status.guestOSInfoбудет отображена информация о запущенной гостевой ОС. - Условие

type: FirmwareUpToDate, status: Falseинформирует о том, что прошивку ВМ требуется обновить. - Условие

type: ConfigurationApplied, status: Falseинформирует о том, что конфигурация ВМ не применена для запущенной ВМ. - Условие

type: SizingPolicyMatched, status: Falseозначает, что конфигурация ресурсов виртуальной машины не соответствует политике сайзинга, заданной в связанном объекте VirtualMachineClass. Чтобы сохранить изменения в конфигурации ВМ, необходимо сначала привести её параметры в соответствие с требованиями этой политики. - Условие

type: AwaitingRestartToApplyConfiguration, status: Trueотображает информацию о необходимости выполнить вручную перезагрузку ВМ, т.к. некоторые изменения конфигурации невозможно применить без перезагрузки ВМ.

- При установленном в гостевой системе qemu-guest-agent, условие

-

Возможные проблемы:

- Внутренний сбой в работе ВМ или гипервизора.

-

Диагностика:

- Проверьте

.status.conditions, условиеtype: Running

d8 k get vm <vm-name> -o json | jq '.status.conditions[] | select(.type=="Running")' - Проверьте

-

-

Stopping- ВМ останавливается или перезагружается -

Stopped- ВМ остановлена и не потребляет вычислительные ресурсы -

Terminating- ВМ удаляется.Данная фаза необратима. Все связанные с ВМ ресурсы освобождаются, но не удаляются автоматически.

-

Migrating- живая миграция ВМВМ переносится на другой узел кластера (живая миграция).

- Особенности:

- Условие

type: Migratableпоказывает, может ли ВМ мигрировать.

- Условие

- Возможные проблемы:

- Несовместимость процессорных инструкций (при использовании типов процессоров host или host-passthrough).

- Различие версиях ядер на узлах гипервизоров.

- На подходящих узлах недостаточно CPU или памяти.

- Превышены квоты неймспейса или проекта.

- Диагностика:

- Проверьте

.status.conditionsусловиеtype: Migrating, а также блок.status.migrationState

- Проверьте

d8 k get vm <vm-name> -o json | jq '.status | {condition: .conditions[] | select(.type=="Migrating"), migrationState}' - Особенности:

Условие type: SizingPolicyMatched, status: False отображает несоответствие конфигурации ресурсов политике сайзинга используемого VirtualMachineClass. При нарушении политики сохранить параметры ВМ без приведения ресурсов в соответствие политике - невозможно.

Условия отображают информацию о состоянии ВМ, а также на возникающие проблемы. Понять, что не так с ВМ можно путем их анализа:

d8 k get vm fedora -o json | jq '.status.conditions[] | select(.message != "")'

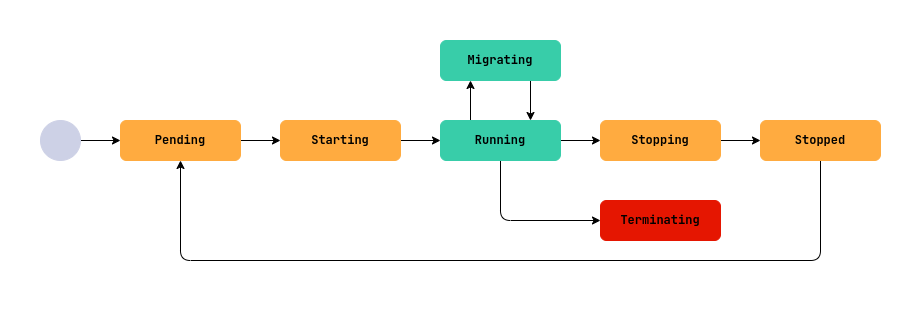

Настройки CPU и coreFraction

При создании виртуальной машины вы можете настроить количество процессорных ресурсов которые она будет использовать, с помощью параметров cores и coreFraction.

Параметр cores задает количество виртуальных ядер процессора выделенных для ВМ.

Параметр coreFraction задаёт гарантированную минимальную долю вычислительной мощности, выделяемой на каждое ядро.

Доступные значения coreFraction могут быть определены в ресурсе VirtualMachineClass для заданного диапазона ядер (cores), допускается использовать только эти значения.

Например, если указать cores: 2, для ВМ будет выделено два виртуальных ядра соответствующих двум физическим ядрам гипервизора.

При coreFraction: 20% ВМ гарантировано получит не менее 20% процессорной мощности каждого ядра, независимо от загрузки узла гипервизора. При этом, если на узле есть свободные ресурсы, ВМ может использовать до 100% мощности каждого ядра, что позволяет достичь максимальной производительности.

Таким образом ВМ гарантировано получает 0.2 CPU каждого физического ядра и может задействовать до 100% мощности двух ядер (2 CPU), если на узле есть незадействованные ресурсы.

Если параметр coreFraction не определен, каждому виртуальному ядру ВМ выделяется 100% ядра физического процессора гипервизора.

Пример конфигурации:

spec:

cpu:

cores: 2

coreFraction: 20%

Такой подход позволяет обеспечить стабильную работу ВМ даже при высокой нагрузке в условиях переподписки процессорных ресурсов, когда виртуальным машинам выделено больше ядер, чем доступно на гипервизоре.

Параметры cores и coreFraction учитываются при планировании размещения ВМ на узлах. Гарантированная мощность (минимальная доля каждого ядра) учитывается при выборе узла, чтобы он мог обеспечить необходимую производительность для всех ВМ. Если узел не располагает достаточными ресурсами для выполнения гарантий, ВМ не будет запущена на этом узле.

Визуализация на примере виртуальных машин со следующими конфигурациями CPU, при размещении их на одном узле:

VM1:

spec:

cpu:

cores: 1

coreFraction: 20%

VM2:

spec:

cpu:

cores: 1

coreFraction: 80%

Настройка ресурсов и политика сайзинга

Политика сайзинга в VirtualMachineClass, заданная в разделе .spec.sizingPolicies, определяет правила настройки ресурсов виртуальных машин, включая количество ядер, объём памяти и долю использования ядер (coreFraction). Эта политика не является обязательной. Если она отсутствует для ВМ, можно указывать произвольные значения для ресурсов без строгих требований. Однако, если политика сайзинга присутствует, конфигурация виртуальной машины должна строго ей соответствовать. В противном случае сохранение конфигурации будет невозможно.

Политика делит количество ядер (cores) на диапазоны, например, 1–4 ядра или 5–8 ядер. Для каждого диапазона указывается, сколько памяти можно выделить (memory) на одно ядро и/или какие значения coreFraction разрешены.

Если конфигурация ВМ (ядра, память или coreFraction) не соответствует политике, в статусе появится условие type: SizingPolicyMatched, status: False.

Если изменить политику в VirtualMachineClass, конфигурацию существующих ВМ может потребоваться изменить в соответствии с новой политикой. Виртуальные машины, не соответствующие условиям новой политики продолжат работать, но любые изменения их конфигурации нельзя будет сохранить до тех пор, пока они не будут соответствовать новым условиям.

Например:

spec:

sizingPolicies:

- cores:

min: 1

max: 4

memory:

min: 1Gi

max: 8Gi

coreFractions: [5, 10, 20, 50, 100]

- cores:

min: 5

max: 8

memory:

min: 5Gi

max: 16Gi

coreFractions: [20, 50, 100]

Если ВМ использует 2 ядра, она попадает в диапазон 1–4 ядра. В этом случае объём памяти можно выбрать от 1 ГБ до 8 ГБ, а coreFraction — только из значений 5%, 10%, 20%, 50% или 100%. Для 6 ядер — диапазон 5–8 ядер, где объём памяти должен составлять от 5 ГБ до 16 ГБ, а coreFraction — 20%, 50% или 100%.

Помимо сайзинга виртуальных машин, политика также позволяет реализовать желаемую максимальную переподписку для ВМ.

Например, указав в политике значение coreFraction: 20%, вы гарантируете любой ВМ не менее 20% вычислительных ресурсов процессора, что фактически определит максимально возможную переподписку в размере 5:1.

Топологии CPU

Топология CPU виртуальной машины (ВМ) определяет, как ядра процессора распределяются по сокетам. Это важно для обеспечения оптимальной производительности и совместимости с приложениями, которые могут зависеть от конфигурации процессора. В конфигурации ВМ вы задаете только общее количество ядер процессора, а топология (количество сокетов и ядер в каждом сокете) рассчитывается автоматически на основе этого значения.

Количество ядер процессора указывается в конфигурации ВМ следующим образом:

spec:

cpu:

cores: 1

Далее система автоматически определяет топологию в зависимости от заданного числа ядер. Правила расчета зависят от диапазона количества ядер и описаны ниже.

- Если количество ядер от 1 до 16 (1 ≤

.spec.cpu.cores≤ 16):- Используется 1 сокет.

- Количество ядер в сокете равно заданному значению.

- Шаг изменения: 1 (можно увеличивать или уменьшать количество ядер по одному).

- Допустимые значения: любое целое число от 1 до 16 включительно.

- Пример: Если задано

.spec.cpu.cores= 8, то топология: 1 сокет с 8 ядрами.

- Если количество ядер от 17 до 32 (16 <

.spec.cpu.cores≤ 32):- Используется 2 сокета.

- Ядра равномерно распределяются между сокетами (количество ядер в каждом сокете одинаковое).

- Шаг изменения: 2 (общее количество ядер должно быть четным).

- Допустимые значения: 18, 20, 22, 24, 26, 28, 30, 32.

- Ограничения: минимум 9 ядер в сокете, максимум 16 ядер в сокете.

- Пример: Если задано

.spec.cpu.cores= 20, то топология: 2 сокета по 10 ядер каждый.

- Если количество ядер от 33 до 64 (32 <

.spec.cpu.cores≤ 64):- Используется 4 сокета.

- Ядра равномерно распределяются между сокетами.

- Шаг изменения: 4 (общее количество ядер должно быть кратно 4).

- Допустимые значения: 36, 40, 44, 48, 52, 56, 60, 64.

- Ограничения: минимум 9 ядер в сокете, максимум 16 ядер в сокете.

- Пример: Если задано

.spec.cpu.cores= 40, то топология: 4 сокета по 10 ядер каждый.

- Если количество ядер больше 64 (

.spec.cpu.cores> 64):- Используется 8 сокетов.

- Ядра равномерно распределяются между сокетами.

- Шаг изменения: 8 (общее количество ядер должно быть кратно 8).

- Допустимые значения: 72, 80, 88, 96 и так далее до 248

- Ограничения: минимум 9 ядер в сокете.

- Пример: Если задано

.spec.cpu.cores= 80, то топология: 8 сокетов по 10 ядер каждый.

Шаг изменения указывает, на сколько можно увеличивать или уменьшать общее количество ядер, чтобы они равномерно распределялись по сокетам.

Максимально возможное количество ядер - 248.

Текущая топология ВМ (количество сокетов и ядер в каждом сокете) отображается в статусе ВМ в следующем формате:

status:

resources:

cpu:

coreFraction: 10%

cores: 1

requestedCores: "1"

runtimeOverhead: "0"

topology:

sockets: 1

coresPerSocket: 1

Сценарии начальной инициализации ВМ

Сценарии начальной инициализации предназначены для первичной конфигурации виртуальной машины при её запуске.

В качестве сценариев начальной инициализации поддерживаются:

Cloud-Init

Cloud-Init — это инструмент для автоматической настройки виртуальных машин при первом запуске. Он позволяет выполнять широкий спектр задач конфигурации без ручного вмешательства.

Конфигурация Cloud-Init записывается в формате YAML и должна начинаться с заголовка #cloud-config в начале блока конфигурации. О других возможных заголовках и их назначении вы можете узнать в официальной документации по cloud-init.

Основные возможности Cloud-Init:

- создание пользователей, установка паролей, добавление SSH-ключей для доступа;

- автоматическая установка необходимого программного обеспечения при первом запуске;

- запуск произвольных команд и скриптов для настройки системы;

- автоматический запуск и включение системных сервисов (например,

qemu-guest-agent).

Типичные сценарии использования

-

Добавление SSH-ключа для предустановленного пользователя, который уже может присутствовать в cloud-образе (например, пользователь

ubuntuв официальных образах Ubuntu). Имя такого пользователя зависит от образа. Уточните его в документации к вашему дистрибутиву.#cloud-config ssh_authorized_keys: - ssh-rsa AAAAB3NzaC1yc2EAAAADAQABAAABAQD... your-public-key ... -

Создание пользователя с паролем и SSH-ключом:

#cloud-config users: - name: cloud passwd: "$6$rounds=4096$saltsalt$..." lock_passwd: false sudo: ALL=(ALL) NOPASSWD:ALL shell: /bin/bash ssh-authorized-keys: - ssh-rsa AAAAB3NzaC1yc2EAAAADAQABAAABAQD... your-public-key ... ssh_pwauth: TrueДля генерации хеша пароля используйте команду

mkpasswd --method=SHA-512 --rounds=4096. -

Установка пакетов и сервисов:

#cloud-config package_update: true packages: - nginx - qemu-guest-agent runcmd: - systemctl daemon-reload - systemctl enable --now nginx.service - systemctl enable --now qemu-guest-agent.service

Использование Cloud-Init

Сценарий Cloud-Init можно встраивать непосредственно в спецификацию виртуальной машины, но этот сценарий ограничен максимальной длиной в 2048 байт:

spec:

provisioning:

type: UserData

userData: |

#cloud-config

package_update: true

...

При более длинных сценариях и/или наличии приватных данных, сценарий начальной инициализации виртуальной машины может быть создан в ресурсе Secret. Пример ресурса Secret со сценарием Cloud-Init приведен ниже:

apiVersion: v1

kind: Secret

metadata:

name: cloud-init-example

data:

userData: <base64 data>

type: provisioning.virtualization.deckhouse.io/cloud-init

Фрагмент конфигурации виртуальной машины при использовании скрипта начальной инициализации Cloud-Init, хранящегося в ресурсе Secret:

spec:

provisioning:

type: UserDataRef

userDataRef:

kind: Secret

name: cloud-init-example

Значение поля .data.userData должно быть закодировано в формате Base64. Для кодирования можно использовать команду base64 -w 0 или echo -n "content" | base64.

Sysprep

Для конфигурирования виртуальных машин под управлением ОС Windows с использованием Sysprep поддерживается только вариант с ресурсом Secret.

Пример ресурса Secret со сценарием Sysprep:

apiVersion: v1

kind: Secret

metadata:

name: sysprep-example

data:

unattend.xml: <base64 data>

type: provisioning.virtualization.deckhouse.io/sysprep

Значение поля .data.unattend.xml должно быть закодировано в формате Base64. Для кодирования можно использовать команду base64 -w 0 или echo -n "content" | base64.

Фрагмент конфигурации виртуальной машины с использованием скрипта начальной инициализации Sysprep в ресурсе Secret:

spec:

provisioning:

type: SysprepRef

sysprepRef:

kind: Secret

name: sysprep-example

Агент гостевой ОС

Для повышения эффективности управления ВМ рекомендуется установить QEMU Guest Agent — инструмент, который обеспечивает взаимодействие между гипервизором и операционной системой внутри ВМ.

Чем поможет агент?

-

Обеспечит создание консистентных снимков дисков и ВМ.

-

Позволит получать информацию о работающей ОС, которая будет отражена в статусе ВМ. Пример:

status: guestOSInfo: id: fedora kernelRelease: 6.11.4-301.fc41.x86_64 kernelVersion: "#1 SMP PREEMPT_DYNAMIC Sun Oct 20 15:02:33 UTC 2024" machine: x86_64 name: Fedora Linux prettyName: Fedora Linux 41 (Cloud Edition) version: 41 (Cloud Edition) versionId: "41" -

Позволит отслеживать, что ОС действительно загрузилась:

d8 k get vm -o wideПример вывода (колонка

AGENT):NAME PHASE CORES COREFRACTION MEMORY NEED RESTART AGENT MIGRATABLE NODE IPADDRESS AGE fedora Running 6 5% 8000Mi False True True virtlab-pt-1 10.66.10.1 5d21h

Как установить QEMU Guest Agent:

Для Debian-based ОС:

sudo apt install qemu-guest-agent

Для Centos-based ОС:

sudo yum install qemu-guest-agent

Запуск службы агента:

sudo systemctl enable --now qemu-guest-agent

Установку агента для Linux ОС можно автоматизировать с помощью сценария первичной инициализации cloud-init. Ниже приведён пример фрагмента такого сценария для установки qemu-guest-agent:

#cloud-config

package_update: true

packages:

- qemu-guest-agent

runcmd:

- systemctl enable --now qemu-guest-agent.service

QEMU Guest Agent не требует дополнительной настройки после установки. Однако для обеспечения консистентности снимков на уровне приложений (без остановки сервисов) можно добавить скрипты, которые будут автоматически выполняться в гостевой ОС до и после операций заморозки (freeze) и оттаивания (thaw) файловой системы. Скрипты должны иметь права на выполнение и размещаться в специальном каталоге, путь к которому зависит от используемого дистрибутива:

/etc/qemu-ga/hooks.d/— для дистрибутивов на базе Debian/Ubuntu;/etc/qemu/fsfreeze-hook.d/— для дистрибутивов на базе RHEL/CentOS/Fedora.

Подключение к виртуальной машине

Для подключения к виртуальной машине доступны следующие способы:

- протокол удаленного управления (например SSH), который должен быть предварительно настроен на виртуальной машине.

- серийная консоль (serial console).

- протокол VNC.

Пример подключения к виртуальной машине с использованием серийной консоли:

d8 v console linux-vm

Пример вывода:

Successfully connected to linux-vm console. The escape sequence is ^]

linux-vm login: cloud

Password: cloud

Нажмите Ctrl+] для завершения работы с серийной консолью.

Пример команды для подключения по VNC:

d8 v vnc linux-vm

Пример команды для подключения по SSH:

d8 v ssh cloud@linux-vm --local-ssh

Как подключиться к виртуальной машине в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Виртуальные машины».

- Из списка выберите необходимую ВМ и нажмите на её имя.

- В открывшейся форме перейдите на вкладку «TTY» для работы с серийной консолью.

- В открывшейся форме перейдите на вкладку «VNC» для подключения по VNC.

- Перейдите в открывшееся окно. Здесь можно подключиться к ВМ.

Политика запуска и управление состоянием ВМ

Политика запуска виртуальной машины предназначена для автоматизированного управления состоянием виртуальной машины. Определяется она в виде параметра .spec.runPolicy в спецификации виртуальной машины. Поддерживаются следующие политики:

AlwaysOnUnlessStoppedManually- (по умолчанию) после создания ВМ всегда находится в запущенном состоянии. В случае сбоев работа ВМ восстанавливается автоматически. Остановка ВМ возможно только путем вызова командыd8 v stopили создания соответствующей операции.AlwaysOn- после создания ВМ всегда находится в работающем состоянии, даже в случае ее выключения средствами ОС. В случае сбоев работа ВМ восстанавливается автоматически.Manual- после создания состоянием ВМ управляет пользователь вручную с использованием команд или операций. ВМ сразу после создания находится в выключенном состоянии. Для включения необходимо выполнить командуd8 v start.AlwaysOff- после создания ВМ всегда находится в выключенном состоянии. Возможность включения ВМ через команды\операции - отсутствует.

Как выбрать политику запуска ВМ в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Виртуальные машины».

- Из списка выберите необходимую ВМ и нажмите на её имя.

- На вкладке «Конфигурация» прокрутите страницу вниз до раздела «Дополнительные параметры».

- Выберите нужную политику из комбобокса «Политика запуска».

Состоянием виртуальной машины можно управлять с помощью следующих методов:

- Создание ресурса

VirtualMachineOperation(vmop). - Использование утилиты

d8с соответствующей подкомандой.

Ресурс VirtualMachineOperation декларативно определяет императивное действие, которое должно быть выполнено на виртуальной машине. Это действие применяется к виртуальной машине сразу после создания соответствующего vmop. Действие применяется к виртуальной машине один раз.

Пример операции для выполнения перезагрузки виртуальной машины с именем linux-vm:

d8 k create -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualMachineOperation

metadata:

generateName: restart-linux-vm-

spec:

virtualMachineName: linux-vm

# Тип применяемой операции = применяемая операция.

type: Restart

EOF

Посмотреть результат действия можно с использованием команды:

d8 k get virtualmachineoperation

# или

d8 k get vmop

Аналогичное действие можно выполнить с использованием утилиты d8:

d8 v restart linux-vm

Перечень возможных операций приведен в таблице ниже:

| d8 | vmop type | Действие |

|---|---|---|

d8 v stop |

Stop |

Остановить ВМ |

d8 v start |

Start |

Запустить ВМ |

d8 v restart |

Restart |

Перезапустить ВМ |

d8 v evict |

Evict |

Мигрировать ВМ на другой узел |

Как выполнить операцию в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Виртуальные машины».

- Из списка выберите нужную виртуальную машину и нажмите кнопку с многоточием.

- Во всплывающем меню можете выбрать возможные операции для ВМ.

Изменение конфигурации ВМ

Конфигурацию виртуальной машины можно изменять в любое время после создания ресурса VirtualMachine. Однако то, как эти изменения будут применены, зависит от текущей фазы виртуальной машины и характера внесённых изменений.

Изменения в конфигурацию виртуальной машины можно внести с использованием следующей команды:

d8 k edit vm linux-vm

Если виртуальная машина находится в выключенном состоянии (.status.phase: Stopped), внесённые изменения вступят в силу сразу после её запуска.

Если виртуальная машина работает (.status.phase: Running), то способ применения изменений зависит от их типа:

| Блок конфигурации | Как применяется |

|---|---|

.metadata.labels |

Сразу |

.metadata.annotations |

Сразу |

.spec.liveMigrationPolicy |

Сразу |

.spec.runPolicy |

Сразу |

.spec.disruptions.restartApprovalMode |

Сразу |

.spec.affinity |

EE, SE+ : Сразу, CE: Требуется перезапуск ВМ |

.spec.nodeSelector |

EE, SE+ : Сразу, CE: Требуется перезапуск ВМ |

.spec.* |

Требуется перезапуск ВМ |

Как изменить конфигурацию ВМ в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Виртуальные машины».

- Из списка выберите необходимую ВМ и нажмите на её имя.

- Вы находитесь на вкладке «Конфигурация», где можете вносить изменения.

- Список измененных параметров и предупреждение, если необходимо перезапустить ВМ, отображаются вверху страницы.

Рассмотрим пример изменения конфигурации виртуальной машины:

Предположим, мы хотим изменить количество ядер процессора. В данный момент виртуальная машина запущена и использует одно ядро, что можно подтвердить, подключившись к ней через серийную консоль и выполнив команду nproc.

d8 v ssh cloud@linux-vm --local-ssh --command "nproc"

Пример вывода:

1

Примените следующий патч к виртуальной машине, чтобы изменить количество ядер с 1 на 2.

d8 k patch vm linux-vm --type merge -p '{"spec":{"cpu":{"cores":2}}}'

# Или внесите аналогичные изменения, отредактировав ресурс.

d8 k edit vm linux-vm

Пример вывода:

# virtualmachine.virtualization.deckhouse.io/linux-vm patched

Изменения в конфигурации внесены, но ещё не применены к виртуальной машине. Проверьте это, повторно выполнив:

d8 v ssh cloud@linux-vm --local-ssh --command "nproc"

Пример вывода:

1

Для применения этого изменения необходим перезапуск виртуальной машины. Выполните следующую команду, чтобы увидеть изменения, ожидающие применения (требующие перезапуска):

d8 k get vm linux-vm -o jsonpath="{.status.restartAwaitingChanges}" | jq .

Пример вывода:

[

{

"currentValue": 1,

"desiredValue": 2,

"operation": "replace",

"path": "cpu.cores"

}

]

Выполните команду:

d8 k get vm linux-vm -o wide

Пример вывода:

NAME PHASE CORES COREFRACTION MEMORY NEED RESTART AGENT MIGRATABLE NODE IPADDRESS AGE

linux-vm Running 2 100% 1Gi True True True virtlab-pt-1 10.66.10.13 5m16s

В колонке NEED RESTART мы видим значение True, а это значит что для применения изменений требуется перезагрузка.

Выполните перезагрузку виртуальной машины:

d8 v restart linux-vm

После перезагрузки изменения будут применены и блок .status.restartAwaitingChanges будет пустой.

Выполните команду для проверки:

d8 v ssh cloud@linux-vm --local-ssh --command "nproc"

Пример вывода:

2

Порядок применения изменений виртуальной машины через «ручной» рестарт является поведением по умолчанию. Если есть необходимость применять внесенные изменения сразу и автоматически, для этого нужно изменить политику применения изменений:

spec:

disruptions:

restartApprovalMode: Automatic

Как выполнить операцию в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Виртуальные машины».

- Из списка выберите необходимую ВМ и нажмите на её имя.

- На вкладке «Конфигурация» прокрутите страницу вниз до раздела «Дополнительные параметры».

- Включите переключатель «Автоприменение изменений».

- Нажмите на появившуюся кнопку «Сохранить».

Размещение ВМ по узлам

Для управления размещением виртуальных машин (параметров размещения) по узлам можно использовать следующие подходы:

- Простое связывание по меткам (

nodeSelector) — базовый способ выбора узлов с заданными метками. - Предпочтительное связывание (

Affinity):nodeAffinity— определяет приоритетные узлы для размещения.virtualMachineAndPodAffinity— обеспечивает совместное размещение ВМ и контейнеров.

- Избежание совместного размещения (

AntiAffinity):virtualMachineAndPodAntiAffinity— предотвращает размещение ВМ и контейнеров на одном узле.

Все указанные параметры (включая параметр .spec.nodeSelector из VirtualMachineClass) применяются комплексно при планировании ВМ. Если хотя бы одно условие не может быть выполнено, запуск ВМ не будет выполнен. Для минимизации рисков рекомендуется:

- Создавать непротиворечивые правила размещения.

- Проверять совместимость правил до их применения.

- Учитывать типы условий:

- Жесткие (

requiredDuringSchedulingIgnoredDuringExecution) — требуют строгого соблюдения. - Мягкие (

preferredDuringSchedulingIgnoredDuringExecution) — допускают частичное выполнение.

- Жесткие (

- Используйте комбинации меток вместо одиночных ограничений. Например, вместо required для одного лейбла (например, env=prod) используйте несколько preferred условий.

- Учитывайте порядок запуска взаимозависимых ВМ. При использовании Affinity между ВМ (например, бэкенд зависит от базы данных) запускайте сначала ВМ, на которые ссылаются правила, чтобы избежать блокировок.

- Планируйте резервные узлы для критических нагрузок. Для ВМ с жесткими требованиями (например, AntiAffinity) предусмотрите дополнительные узлы, чтобы избежать простоев при сбое или выводе узла в режим обслуживания.

- Учитывайте существующие ограничения (

taints) на узлах. При необходимости можно добавить соответствующиеtolerationsдля ВМ. Пример использованияtolerationsдля разрешения запуска на узлах с taintnode.deckhouse.io/group=:NoSchedule:

spec:

tolerations:

- key: "node.deckhouse.io/group"

operator: "Exists"

effect: "NoSchedule"

При изменении параметров размещения:

-

Если текущее расположение ВМ соответствует новым требованиям, она остается на текущем узле.

-

Если требования нарушаются:

- В платных редакциях: ВМ автоматически перемещается на подходящий узел с помощью живой миграции.

- В CE-редакции: для применения ВМ будет требоваться перезагрузка.

Как управлять параметрами размещения ВМ по узлам в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Виртуальные машины».

- Из списка выберите необходимую ВМ и нажмите на её имя.

- На вкладке «Конфигурация» прокрутите страницу до раздела «Размещение».

Простое связывание по меткам (nodeSelector)

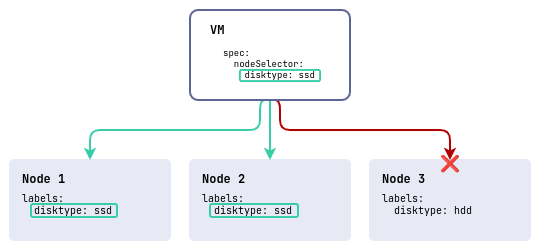

nodeSelector — это простейший способ контролировать размещение виртуальных машин, используя набор меток. Он позволяет задать, на каких узлах могут запускаться виртуальные машины, выбирая узлы с необходимыми метками.

spec:

nodeSelector:

disktype: ssd

В этом примере в кластере три узла: два с быстрыми дисками (disktype=ssd) и один с медленными (disktype=hdd). Виртуальная машина будет размещена только на узлах, которые имеют метку disktype со значением ssd.

Как выполнить операцию в веб-интерфейсе в разделе «Размещение»:

- Нажмите «Добавить» в блоке «Запустить по узлам» → «Выберите узлы по лейблам».

- Во всплывающем окне можете задать «Ключ», «Значение» ключа, что соответствует настройкам

spec.nodeSelector. - Для подтверждения параметров ключа нажмите кнопку «Enter».

- Нажмите на появившуюся кнопку «Сохранить».

Предпочтительное связывание (Affinity)

Affinity предоставляет более гибкие и мощные инструменты по сравнению с nodeSelector. Он позволяет задавать «предпочтения» и «обязательности» для размещения виртуальных машин. Affinity поддерживает два вида: nodeAffinity и virtualMachineAndPodAffinity.

Требования к размещению могут быть:

- Жёсткие (

requiredDuringSchedulingIgnoredDuringExecution) — ВМ размещается только на узлах, удовлетворяющих условию. - Мягкие (

preferredDuringSchedulingIgnoredDuringExecution) — ВМ размещается на подходящих узлах, если это возможно.

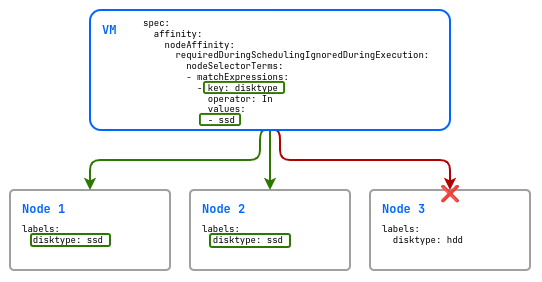

nodeAffinity — определяет узлы для запуска ВМ с помощью выражений селекторов меток.

Пример использования nodeAffinity с жестким правилом:

spec:

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: disktype

operator: In

values:

- ssd

В этом примере в кластере три узла: два с быстрыми дисками (disktype=ssd) и один с медленными (disktype=hdd). Виртуальная машина будет размещена только на узлах, которые имеют метку disktype со значением ssd.

Если использовать мягкое требование (preferredDuringSchedulingIgnoredDuringExecution), то при отсутствии ресурсов для запуска ВМ на узлах с дисками disktype=ssd она будет запланирована на узле с дисками disktype=hdd.

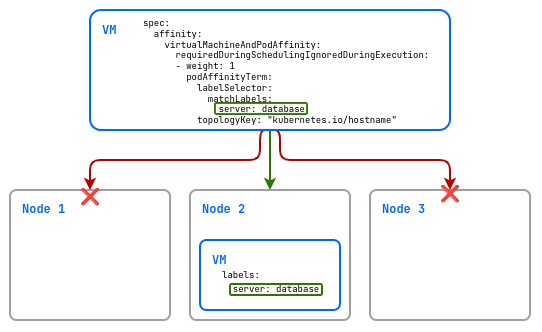

virtualMachineAndPodAffinity управляет размещением виртуальных машин относительно других виртуальных машин. Он позволяет задавать предпочтение размещения виртуальных машин на тех же узлах, где уже запущены определенные виртуальные машины.

Пример мягкого правила:

spec:

affinity:

virtualMachineAndPodAffinity:

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 1

podAffinityTerm:

labelSelector:

matchLabels:

server: database

topologyKey: "kubernetes.io/hostname"

В этом примере виртуальная машина будет размещена, если будет такая возможность (тк используется preferred) только на узлах на которых присутствует виртуальная машина с меткой server и значением database.

Как задавать «предпочтения» и «обязательности» для размещения виртуальных машин в веб-интерфейсе в разделе «Размещение»:

- Нажмите «Добавить» в блоке «Запустить ВМ рядом с другими ВМ».

- Во всплывающем окне можете задать «Ключ», «Значение» ключа, что соответствует настройкам

spec.affinity.virtualMachineAndPodAffinity. - Для подтверждения параметров ключа нажмите кнопку «Enter».

- Выберите одну из опций

На одном сервереилиВ одной зоне, что соответствует параметруtopologyKey. - Нажмите на появившуюся кнопку «Сохранить».

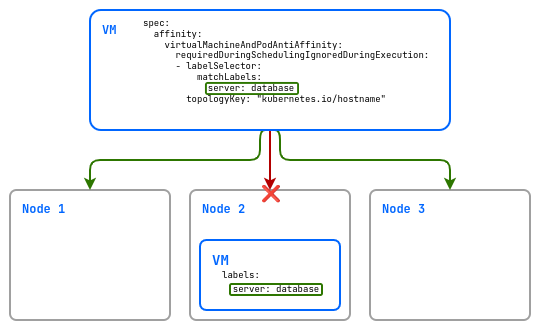

Избежание совместного размещения (AntiAffinity)

AntiAffinity используется для предотвращения совместного размещения ВМ на узлах. Полезно для обеспечения отказоустойчивости или балансировки нагрузки.

Требования к размещению могут быть:

- Жёсткие (

requiredDuringSchedulingIgnoredDuringExecution) — ВМ размещается только на узлах, удовлетворяющих условию. - Мягкие (

preferredDuringSchedulingIgnoredDuringExecution) — ВМ размещается на подходящих узлах, если это возможно.

Будьте осторожны при использовании жестких требований в небольших кластерах, где мало узлов для запуска виртуальных машин (ВМ). Если используется параметр virtualMachineAndPodAntiAffinity с типом requiredDuringSchedulingIgnoredDuringExecution для виртуальных машин, это означает, что каждая копия ВМ должна размещаться на отдельном узле. В условиях ограниченного количества узлов в кластере это может привести к ситуации, когда некоторые ВМ не смогут быть запущены из-за недостатка доступных узлов.

Термины Affinity и AntiAffinity применимы только к отношению между виртуальными машинами. Для узлов используемые привязки называются nodeAffinity. В nodeAffinity нет отдельного антитеза, как в случае с virtualMachineAndPodAffinity, но можно создать противоположные условия, задав отрицательные операторы в выражениях меток: чтобы акцентировать внимание на исключении определенных узлов, можно воспользоваться nodeAffinity с оператором, таким как NotIn.

Пример использования virtualMachineAndPodAntiAffinity:

spec:

affinity:

virtualMachineAndPodAntiAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

- labelSelector:

matchLabels:

server: database

topologyKey: "kubernetes.io/hostname"

В данном примере создаваемая виртуальная машина не будет размещена на одном узле с виртуальной машиной с меткой server: database.

Как настроить предотвращение совместного размещения ВМ на узлах в веб-интерфейсе в разделе «Размещение»:

- Нажмите «Добавить» в блоке «Определять схожие ВМ по лейблам» → «Выберите лейблы».

- Во всплывающем окне можете задать «Ключ», «Значение» ключа, что соответствует настройкам

spec.affinity.virtualMachineAndPodAntiAffinity. - Для подтверждения параметров ключа нажмите кнопку «Enter».

- Установите галочку рядом с теми лейблами, которые хотите использовать в настройке размещения.

- Выберите одну из опций в разделе «Выберите опции».

- Нажмите на появившуюся кнопку «Сохранить».

Подключение блочных устройств (диски и образы)

Блочные устройства можно разделить на два типа по способу их подключения: статические и динамические (hotplug).

Блочные устройства и их особенности представлены в таблице:

| Тип блочного устройства | Комментарий |

|---|---|

VirtualImage |

подключается в режиме для чтения, или как cdrom для iso-образов |

ClusterVirtualImage |

подключается в режиме для чтения, или как cdrom для iso-образов |

VirtualDisk |

подключается в режиме для чтения и записи |

Загрузочные блочные устройства

Загрузочные блочные устройства указываются в спецификации виртуальной машины в блоке .spec.blockDeviceRefs в виде списка. Порядок устройств в этом списке определяет последовательность их загрузки. Таким образом, если диск или образ указан первым, загрузчик сначала попробует загрузиться с него. Если это не удастся, система перейдет к следующему устройству в списке и попытается загрузиться с него. И так далее до момента обнаружения первого загрузчика.

Изменение состава и порядка устройств в блоке .spec.blockDeviceRefs возможно только с перезагрузкой виртуальной машины.

Фрагмент конфигурации VirtualMachine со статически подключенными диском и проектным образом:

spec:

blockDeviceRefs:

- kind: VirtualDisk

name: <virtual-disk-name>

- kind: VirtualImage

name: <virtual-image-name>

Как работать со загрузочными блочными устройствами в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Виртуальные машины».

- Из списка выберите необходимую ВМ и нажмите на её имя.

- На вкладке «Конфигурация» прокрутите страницу до раздела «Диски и образы».

- Вы можете добавлять, извлекать, удалять, изменять размер, менять порядок загрузочных блочных устройств в секции «Загрузочные диски».

Дополнительные блочные устройства

Дополнительные блочные устройства можно подключать и отключать от виртуальной машины, находящейся в запущенном состоянии, без необходимости её перезагрузки.

Для подключения дополнительных блочных устройств используется ресурс VirtualMachineBlockDeviceAttachment (vmbda).

Создайте ресурс, который подключит пустой диск blank-disk к виртуальной машине linux-vm:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualMachineBlockDeviceAttachment

metadata:

name: attach-blank-disk

spec:

blockDeviceRef:

kind: VirtualDisk

name: blank-disk

virtualMachineName: linux-vm

EOF

После создания VirtualMachineBlockDeviceAttachment может находиться в следующих состояниях (фазах):

Pending- ожидание готовности всех зависимых ресурсов.InProgress- идет процесс подключения устройства.Attached- устройство подключено.

Диагностика проблем с ресурсом осуществляется путем анализа информации в блоке .status.conditions.

Проверьте состояние вашего ресурса:

d8 k get vmbda attach-blank-disk

Пример вывода:

NAME PHASE VIRTUAL MACHINE NAME AGE

attach-blank-disk Attached linux-vm 3m7s

Подключитесь к виртуальной машине и удостоверитесь, что диск подключен:

d8 v ssh cloud@linux-vm --local-ssh --command "lsblk"

Пример вывода:

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 10G 0 disk <--- статично подключенный диск linux-vm-root

|-sda1 8:1 0 9.9G 0 part /

|-sda14 8:14 0 4M 0 part

`-sda15 8:15 0 106M 0 part /boot/efi

sdb 8:16 0 1M 0 disk <--- cloudinit

sdc 8:32 0 95.9M 0 disk <--- динамически подключенный диск blank-disk

Для отключения диска от виртуальной машины удалите ранее созданный ресурс:

d8 k delete vmbda attach-blank-disk

Подключение образов, осуществляется по аналогии. Для этого в качестве kind указать VirtualImage или ClusterVirtualImage и имя образа:

d8 k apply -f - <<EOF

apiVersion: virtualization.deckhouse.io/v1alpha2

kind: VirtualMachineBlockDeviceAttachment

metadata:

name: attach-ubuntu-iso

spec:

blockDeviceRef:

kind: VirtualImage # или ClusterVirtualImage

name: ubuntu-iso

virtualMachineName: linux-vm

EOF

Как работать с дополнительными блочными устройствами в веб-интерфейсе:

- Перейдите на вкладку «Проекты» и выберите нужный проект.

- Перейдите в раздел «Виртуализация» → «Виртуальные машины».

- Из списка выберите необходимую ВМ и нажмите на её имя.

- На вкладке «Конфигурация» прокрутите страницу до раздела «Диски и образы».

- Вы можете добавлять, извлекать, удалять, изменять размер дополнительных блочных устройств в секции «Дополнительные диски».

Организация взаимодействия с ВМ

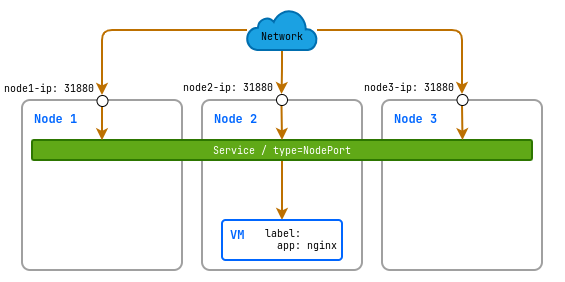

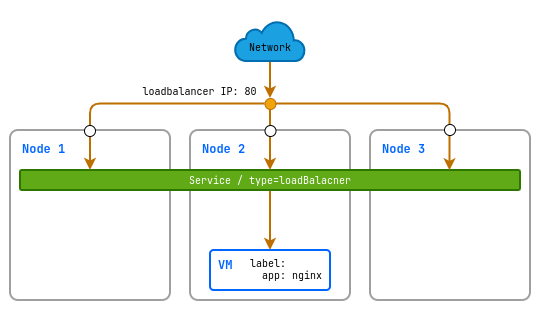

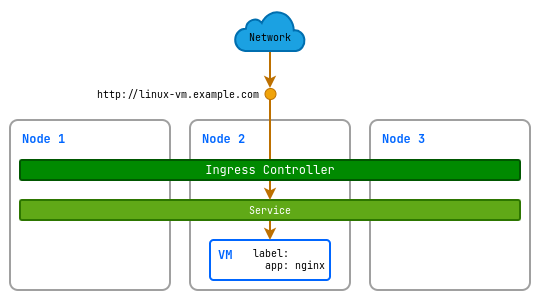

К виртуальным машинам можно обращаться напрямую по их фиксированным IP-адресам. Однако такой подход имеет ограничения: прямое использование IP-адресов требует ручного управления, усложняет масштабирование и делает инфраструктуру менее гибкой. Альтернативой служат сервисы — механизм, который абстрагирует доступ к ВМ, предоставляя логические точки входа вместо привязки к физическим адресам.

Сервисы упрощают взаимодействие как с отдельными ВМ, так и с группами подобных ВМ. Например, тип сервиса ClusterIP создаёт фиксированный внутренний адрес, через который можно обращаться как к одной, так и к группе ВМ, независимо от их реальных IP-адресов. Это позволяет другим компонентам системы взаимодействовать с ресурсами через стабильное имя или IP, автоматически направляя трафик к нужным машинам.

Сервисы также служат инструментом балансировки нагрузки: они равномерно распределяют запросы между всеми связанными машинами, обеспечивая отказоустойчивость и простоту расширения без необходимости перенастройки клиентов.